摘要:在深度学习中,处理多个损失平衡的策略至关重要。通过对不同损失函数的权衡和优化,可以提高模型的性能和泛化能力。常见的多个损失平衡策略包括加权求和、动态调整权重和使用不同的优化器针对特定损失等。这些策略有助于在训练过程中平衡不同任务或目标的重要性,从而提高模型的准确性和鲁棒性。

本文目录导读:

在深度学习中,我们经常遇到多任务学习场景,即一个模型需要同时处理多个子任务,每个子任务对应一个损失函数(loss),如何平衡这些损失,使得模型在各项任务上都能取得良好的性能,是一个重要的问题,本文将探讨深度学习中多个损失的平衡策略。

深度学习中多个损失的出现背景

在复杂的机器学习任务中,单一的目标函数往往难以涵盖所有的需求,我们可能需要设计多个损失函数来分别优化不同的性能指标,在图像识别任务中,我们可能既关注识别的准确率,又关注模型的鲁棒性,这就需要设计不同的损失函数来分别优化这两个目标,多个损失函数的引入也带来了新的问题,即如何平衡这些损失,使得模型能在各个任务上都能取得良好的性能。

多个损失的平衡策略

1、权重法:最直接的方法是给每个损失函数分配一个权重,然后将这些损失加权求和,得到一个总损失,权重的选择需要根据任务的重要性和难度来确定,这种方法简单直观,但权重的选择对模型性能影响较大,需要一定的调参技巧。

2、梯度归一化:由于不同任务的梯度大小可能差异较大,因此在进行梯度下降时,可能会导致某些任务的梯度被其他任务压制,为了解决这个问题,我们可以对梯度进行归一化,使得每个任务的梯度在相同的尺度上进行更新,这种方法可以有效地避免某些任务过度优化而其他任务性能不佳的情况。

3、动态权重调整:在训练过程中,可以根据每个任务的性能动态调整损失的权重,当某个任务的性能较差时,可以增大其对应的损失权重,使其在后续的训练过程中得到更多的关注,这种方法的优点是能够自适应地调整不同任务的优化程度,但缺点是调参较为复杂。

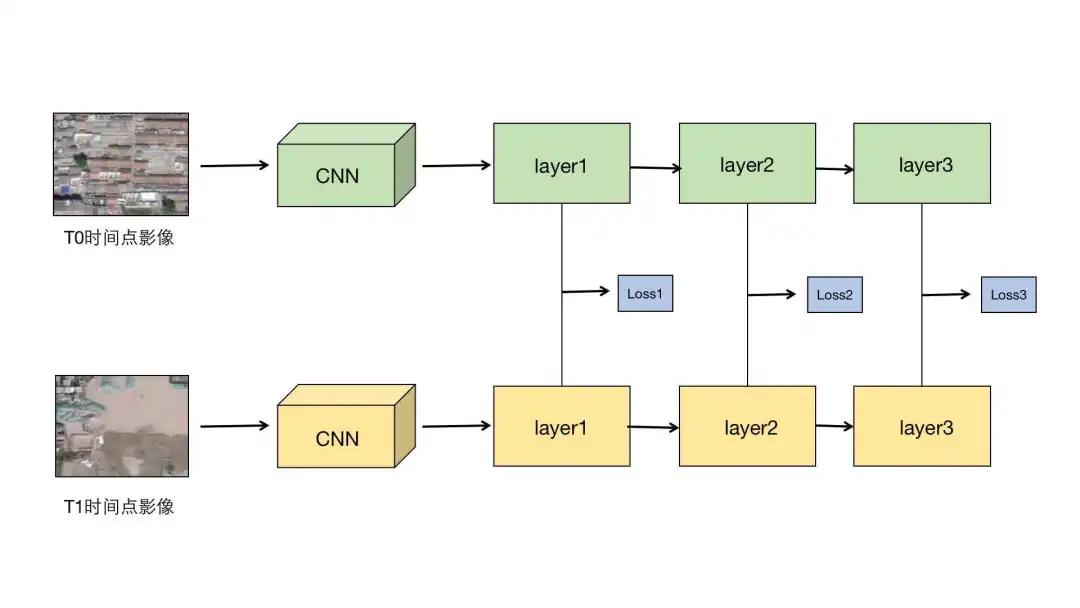

4、协同训练:在某些情况下,不同任务之间可能存在某种关联或共享信息,我们可以利用这种关联来协同训练模型,使得不同任务能够相互促进,可以使用一个共享的特征提取器来处理多个任务的数据,然后为每个任务分别设计一个特定的子网络,这种方法的优点是能够充分利用任务间的关联信息,提高模型的性能。

5、渐进式训练:在多任务学习场景中,我们可以分阶段进行训练,我们专注于优化一个主要任务,待其性能稳定后,再引入其他任务进行联合训练,通过这种方式,我们可以逐步平衡各个任务的性能,避免在训练初期由于任务间的冲突导致模型性能下降。

实验与评估

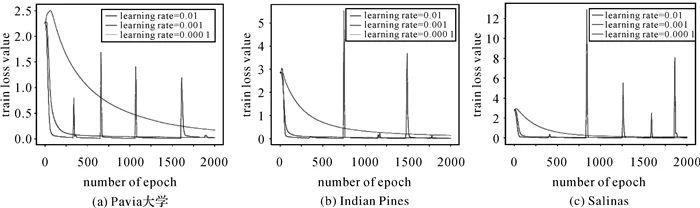

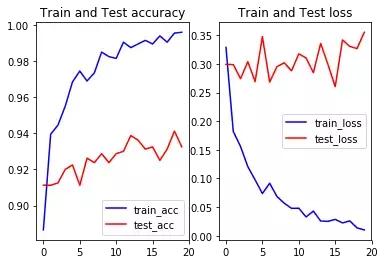

为了验证上述策略的有效性,我们进行了多项实验,实验结果表明,通过合理的平衡策略,我们可以有效地提高模型在多个任务上的性能,我们还发现,不同的任务和数据集可能需要采用不同的平衡策略,因此在实际应用中需要根据具体情况进行选择。

本文探讨了深度学习中多个损失的平衡策略,通过介绍多种平衡策略并进行实验验证,我们得出结论:合理的平衡策略可以有效地提高模型在多个任务上的性能,我们将继续研究更高效的平衡策略,以应对更复杂的机器学习任务。

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号